O crescente custo energético e ambiental do boom da inteligência artificial está alimentando preocupações. Mecanismos de política verde que já existem oferecem um caminho para uma solução

À medida que mais data centers surgem em comunidades rurais, a oposição local a eles tem crescido. Crédito: Brian Lawless/PA/Alamy

Por Sasha Luccioni , Boris Gamazaychikov , Sara Hooker , Régis Pierrard , Emma Strubell , Yacine Jernite e Carole-Jean Wu para a Nature

À medida que milhões de pessoas usam cada vez mais modelos de inteligência artificial generativa (IA) para tarefas que vão desde pesquisas na Web até a criação de videoclipes , há uma urgência crescente em minimizar a pegada energética da tecnologia.

O preocupante custo ambiental da IA é óbvio mesmo neste estágio inicial de sua evolução. Um relatório publicado em 1º de janeiro pela Agência Internacional de Energia estimou que o consumo de eletricidade dos data centers pode dobrar até 2026 e sugeriu que melhorias na eficiência serão cruciais para moderar esse aumento esperado.

Alguns líderes da indústria de tecnologia têm procurado minimizar o impacto na rede de energia. Eles sugerem que a IA poderia permitir avanços científicos que podem resultar em uma redução nas emissões de carbono planetárias . Outros têm jogado seu peso por trás de fontes de energia ainda não realizadas, como a fusão nuclear .

No entanto, do jeito que as coisas estão, as demandas de energia da IA estão mantendo as antigas usinas de energia a carvão em serviço e aumentando significativamente as emissões das empresas que fornecem o poder de computação para essa tecnologia. Dado que o consenso claro entre os cientistas do clima é que o mundo enfrenta um momento de “agora ou nunca” para evitar mudanças planetárias irreversíveis 2 , reguladores, formuladores de políticas e empresas de IA devem abordar o problema imediatamente.

Para começar, estruturas de políticas que incentivam a eficiência energética ou de combustível em outros setores econômicos podem ser modificadas e aplicadas a aplicações alimentadas por IA. Esforços para monitorar e comparar os requisitos de energia da IA — e as emissões de carbono associadas — devem ser estendidos além da comunidade de pesquisa. Dar ao público uma maneira simples de tomar decisões informadas eliminaria a divisão que agora existe entre os desenvolvedores e os usuários de modelos de IA, e poderia eventualmente provar ser um divisor de águas.

Este é o objetivo de uma iniciativa chamada projeto AI Energy Star, que descrevemos aqui e recomendamos como um modelo que os governos e a comunidade de código aberto podem adotar. O projeto é inspirado nas classificações Energy Star da Agência de Proteção Ambiental dos EUA . Elas fornecem aos consumidores uma medida transparente e direta do consumo de energia associado a produtos que vão de máquinas de lavar a carros. O programa ajudou a atingir mais de 4 bilhões de toneladas de reduções de gases de efeito estufa nos últimos 30 anos, o equivalente a tirar quase 30 milhões de carros movidos a gasolina das ruas por ano.

O objetivo do projeto AI Energy Star é semelhante: ajudar desenvolvedores e usuários de modelos de IA a levar em conta o consumo de energia. Ao testar uma gama suficientemente diversa de modelos de IA para um conjunto de casos de uso populares, podemos estabelecer uma faixa esperada de consumo de energia e, em seguida, classificar os modelos dependendo de onde eles se encontram nessa faixa, com aqueles que consomem menos energia recebendo a classificação mais alta. Este sistema simples pode ajudar os usuários a escolher os modelos mais apropriados para seu caso de uso rapidamente. Espera-se que uma maior transparência também incentive os desenvolvedores de modelos a considerar o uso de energia como um parâmetro importante, resultando em uma redução em toda a indústria nas emissões de gases de efeito estufa.

Ferramentas para quantificar o uso de energia da IA podem melhorar a eficiência e a sustentabilidade. Crédito: Getty

Nosso benchmarking inicial foca em um conjunto de modelos de código aberto hospedados no Hugging Face, um repositório líder para modelos de IA. Embora alguns dos chatbots amplamente usados lançados pelo Google e OpenAI ainda não façam parte do nosso conjunto de testes, esperamos que empresas privadas participem do benchmarking de seus modelos proprietários à medida que o interesse do consumidor no tópico cresce.

A avaliação

Um único modelo de IA pode ser usado para uma variedade de tarefas — variando de resumo a reconhecimento de fala — então nós selecionamos um conjunto de dados para refletir esses diversos casos de uso. Por exemplo, para detecção de objetos, nós recorremos ao COCO 2017 e ao Visual Genome — ambos conjuntos de dados de avaliação estabelecidos usados para pesquisa e desenvolvimento de modelos de IA — assim como o conjunto de dados Plastic in River , composto de exemplos anotados de objetos plásticos flutuantes em cursos d’água.

Nós decidimos por dez maneiras populares nas quais a maioria dos consumidores usa modelos de IA, por exemplo, como um chatbot de resposta a perguntas ou para geração de imagens. Então, extraímos uma amostra representativa do conjunto de dados de avaliação específica da tarefa. Nosso objetivo era medir a quantidade de energia consumida para responder a 1.000 consultas. O pacote de código aberto CodeCarbon foi usado para rastrear a energia necessária para calcular as respostas. Os experimentos foram realizados executando o código em unidades de processamento gráfico NVIDIA de última geração, refletindo configurações de implantação baseadas em nuvem usando hardware especializado, bem como nas unidades de processamento central de computadores disponíveis comercialmente.

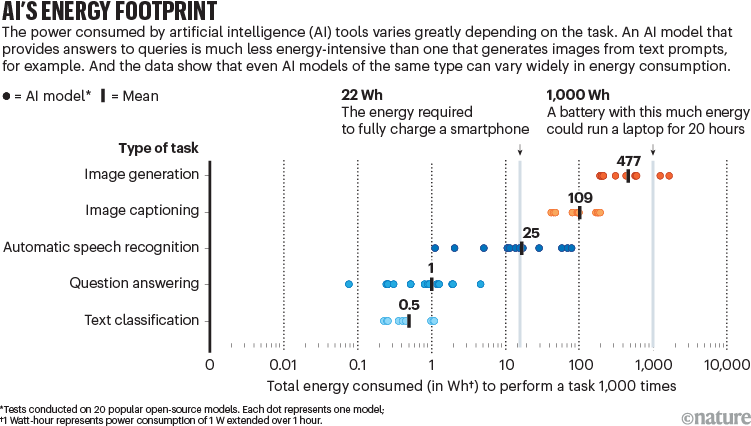

Em nosso conjunto inicial de experimentos, avaliamos mais de 200 modelos de código aberto da plataforma Hugging Face, escolhendo os 20 mais populares (por número de downloads) para cada tarefa. Nossas descobertas iniciais mostram que tarefas envolvendo classificação e geração de imagens geralmente resultam em emissões de carbono milhares de vezes maiores do que aquelas envolvendo apenas texto (veja ‘Pegada energética da IA’). Indústrias criativas que consideram a adoção em larga escala da IA, como a produção de filmes, devem tomar nota.

Fonte: Análise não publicada por S. Luccioni et al. / Projeto AI Energy Star

Dentro do nosso conjunto de amostra, o modelo de perguntas e respostas mais eficiente usou aproximadamente 0,1 watt-hora (aproximadamente a energia necessária para alimentar uma lâmpada incandescente de 25 W por 5 minutos) para processar 1.000 perguntas. O modelo de geração de imagens menos eficiente, por outro lado, exigiu até 1.600 Wh para criar 1.000 imagens de alta definição — essa é a energia necessária para carregar totalmente um smartphone aproximadamente 70 vezes , totalizando uma diferença de 16.000 vezes. À medida que milhões de pessoas integram modelos de IA em seu fluxo de trabalho, as tarefas em que eles os implantam serão cada vez mais importantes.

Em geral, tarefas supervisionadas como responder perguntas ou classificar textos — nas quais os modelos recebem um conjunto de opções para escolher ou um documento que contém a resposta — são muito mais eficientes em termos de energia do que tarefas generativas que dependem dos padrões aprendidos dos dados de treinamento para produzir uma resposta do zero 3 . Além disso, tarefas de sumarização e classificação de texto usam relativamente pouca energia, embora deva ser observado que quase todos os casos de uso que envolvem grandes modelos de linguagem são mais intensivos em energia do que uma pesquisa no Google (consultar um chatbot de IA uma vez usa cerca de dez vezes a energia necessária para processar uma solicitação de pesquisa na web).

Essas classificações podem ser usadas por desenvolvedores para escolher arquiteturas de modelos mais eficientes para otimizar o uso de energia. Isso já é possível, como mostrado por nossos testes ainda não publicados em modelos de tamanhos semelhantes (determinados com base no número de conexões na rede neural). Para uma tarefa específica, como geração de texto, um modelo de linguagem chamado OLMo-7B, criado pelo Allen Institute em Seattle, Washington, consumiu 43 Wh para gerar 1.000 respostas de texto, enquanto o Gemma-7B do Google e um chamado Yi-6B LLM, da empresa 01.AI, sediada em Pequim, usaram 53 Wh e 147 Wh, respectivamente.

Com uma gama de opções já existentes, classificações por estrelas baseadas em classificações como a nossa podem levar os desenvolvedores de modelos a reduzir sua pegada energética. Da nossa parte, lançaremos um site de classificação de estrelas de IA Energy Star, juntamente com uma plataforma de testes centralizada que pode ser usada para comparar e referenciar modelos conforme eles forem lançados. Os limites de energia para cada classificação por estrelas mudarão se a indústria se mover na direção certa. É por isso que pretendemos atualizar as classificações rotineiramente e oferecer aos usuários e organizações uma métrica útil, além do desempenho, para avaliar quais modelos de IA são os mais adequados.

As recomendações

Para atingir um progresso significativo, é essencial que todos os stakeholders tomem medidas proativas para garantir o crescimento sustentável da IA. As recomendações a seguir fornecem algumas orientações específicas para a variedade de players envolvidos.

Envolva os desenvolvedores. Pesquisadores e desenvolvedores de IA estão no centro da inovação neste campo. Ao considerar a sustentabilidade durante todo o ciclo de desenvolvimento e implantação, eles podem reduzir significativamente o impacto ambiental da IA desde o início. Para tornar uma prática padrão medir e compartilhar publicamente o uso de energia dos modelos (por exemplo, em um “cartão de modelo” que define informações como dados de treinamento, avaliações de desempenho e metadados), é essencial envolver os desenvolvedores.

Impulsione o mercado em direção à sustentabilidade. Empresas e desenvolvedores de produtos desempenham um papel crucial na implantação e uso comercial de tecnologias de IA. Seja criando um produto autônomo, aprimorando software existente ou adotando IA para processos comerciais internos, esses grupos geralmente são tomadores de decisão importantes na cadeia de valor de IA. Ao exigir modelos de eficiência energética e definir padrões de aquisição, eles podem impulsionar o mercado em direção a soluções sustentáveis. Por exemplo, eles podem definir expectativas básicas (como exigir que os modelos alcancem pelo menos duas estrelas de acordo com o esquema AI Energy Star) ou apoiar a legislação de IA sustentável.

Divulgue o consumo de energia. Usuários de IA estão na linha de frente, interagindo com produtos de IA em várias aplicações. Uma preferência por soluções de eficiência energética pode enviar um sinal de mercado poderoso, encorajando desenvolvedores e empresas a priorizar a sustentabilidade. Usuários podem empurrar a indústria na direção certa ao optar por modelos que divulguem publicamente o consumo de energia. Eles também podem usar produtos de IA de forma mais consciente, evitando o uso desnecessário e desperdiçável.

Fortalecer a regulamentação e a governança. Os formuladores de políticas têm autoridade para tratar a sustentabilidade como um critério obrigatório no desenvolvimento e na implantação de IA. Com exemplos recentes de legislação que pede transparência do impacto da IA na União Europeia e nos Estados Unidos , os formuladores de políticas já estão se movendo em direção a uma maior responsabilização. Isso pode ser inicialmente voluntário, mas eventualmente os governos podem regular a implantação do sistema de IA com base na eficiência dos modelos subjacentes.

Os reguladores podem adotar uma visão panorâmica , e sua contribuição será crucial para criar padrões globais. Também pode ser importante estabelecer autoridades independentes para rastrear mudanças no consumo de energia da IA ao longo do tempo.

Fazendo um balanço

Claramente, muito mais precisa ser feito para colocar um regime regulatório adequado em prática antes que a adoção em massa da IA se torne uma realidade (veja go.nature.com/4dfp1wb ). O projeto AI Energy Star é um pequeno começo e pode ser refinado ainda mais. Atualmente, não contabilizamos as despesas gerais de energia gastas em armazenamento e rede de modelos, bem como o resfriamento do data center, que pode ser medido apenas com acesso direto às instalações da nuvem. Isso significa que nossos resultados representam o limite inferior do consumo geral de energia dos modelos de IA, que provavelmente dobrará 4 se a despesa geral associada for levada em consideração.

Como o uso de energia se traduz em emissões de carbono também dependerá de onde os modelos são finalmente implantados e da mistura de energia disponível naquela cidade ou vila. O maior desafio, no entanto, continuará sendo a impenetrabilidade do que está acontecendo no ecossistema de modelos proprietários. Os reguladores governamentais estão começando a exigir acesso a modelos de IA, especialmente para garantir a segurança. Maior transparência é urgentemente necessária porque os modelos proprietários são amplamente implantados em configurações voltadas para o usuário.

O mundo está agora em um ponto de inflexão fundamental. As decisões que estão sendo tomadas hoje repercutirão por décadas, à medida que a tecnologia de IA evolui junto com um clima planetário cada vez mais instável. Esperamos que o projeto Energy Star sirva como um ponto de partida valioso para enviar uma forte demanda de sustentabilidade por toda a cadeia de valor de IA.

Natureza 632 , 736-738 (2024)

doi: https://doi.org/10.1038/d41586-024-02680-3

Isenção de responsabilidade: todos os experimentos e processamento de dados foram realizados pela Hugging Face, e a Hugging Face hospeda todos os dados relacionados a esta pesquisa.

Referências

-

Agência Internacional de Energia. Eletricidade 2024 (IEA, 2024).

-

IPCC. Mudanças Climáticas 2022: Mitigação das Mudanças Climáticas. Contribuição do Grupo de Trabalho III para o Sexto Relatório de Avaliação do Painel Intergovernamental sobre Mudanças Climáticas (eds Shukla, PR et al. ) (Cambridge Univ. Press, 2023).

-

Luccioni, AS, Jernite, Y. & Strubell, E. em Proc. Conferência ACM 2024. Justiça, conta. Transpar. 85–99 (ACM, 2024).

-

Luccioni, AS, Viguier, S. & Ligozat, AR J. Machin. Aprender. Res. 24 , 253 (2023).

Fonte: Nature